前提と注意事項

この記事では以下を前提としています。

- 検証した macOS のバージョンは Sonoma 14.0

- 検証機は Macbookpro M1 Pro 2021 のメモリ 32GB モデルになります。

この記事のゴール

以下のように macOS のターミナルで Llama3 について質問して回答を得られる環境を構築することをゴールとします。

>>> how are you ?

Im just an AI, so I don't have emotions like humans do. However, I'm functioning

properly and ready to assist you with any questions or tasks you may have. How can

I help you today?日本語での質問にも回答してくれますが、Llama3 そのままでは英語での回答がされます。

>>> 日本の首都はどこですか?

That’s an easy one! 🙏 The capital of Japan is Tokyo (, Tokyō).Ollama について

Ollama は、AI モデルを簡単にダウンロードして実行できるツールです。Ollama を使うことで、AI モデルをダウンロードして実行するための環境を構築することができます。記事執筆時点では、Windows(プレビュー版)、macOS、Linux に対応しています。 以下が Ollama の公式サイトです。

コードも公開されており、以下が GitHub リポジトリになります。

本記事では、Ollama を使って macOS で Meta 社が公開しているオープンソースの AI モデルである Llama3 を動かすまでの手順を解説します。

Ollama をインストールする

まずOllama の公式サイトでDownloadボタンをクリックします。

以下のように表示されるので、今回はDownload for macOSボタンをクリックして macOS 用のものをダウンロードします。

記事執筆時点ではOllama-darwin.zipというファイルがダウンロードされます。サイズは 184.3MB でした。これをダブルクリックしてアーカイブユーティリティで展開します。(ダブルクリックしても展開できない場合は、Zip ファイル上で右クリック →「このアプリケーションで開く」→「アーカイブユーティリティ.app」で展開できます。)

展開すると、Ollama.appというファイルが作成されます。これをダブルクリックして起動します。起動すると以下のような画面が表示されます。

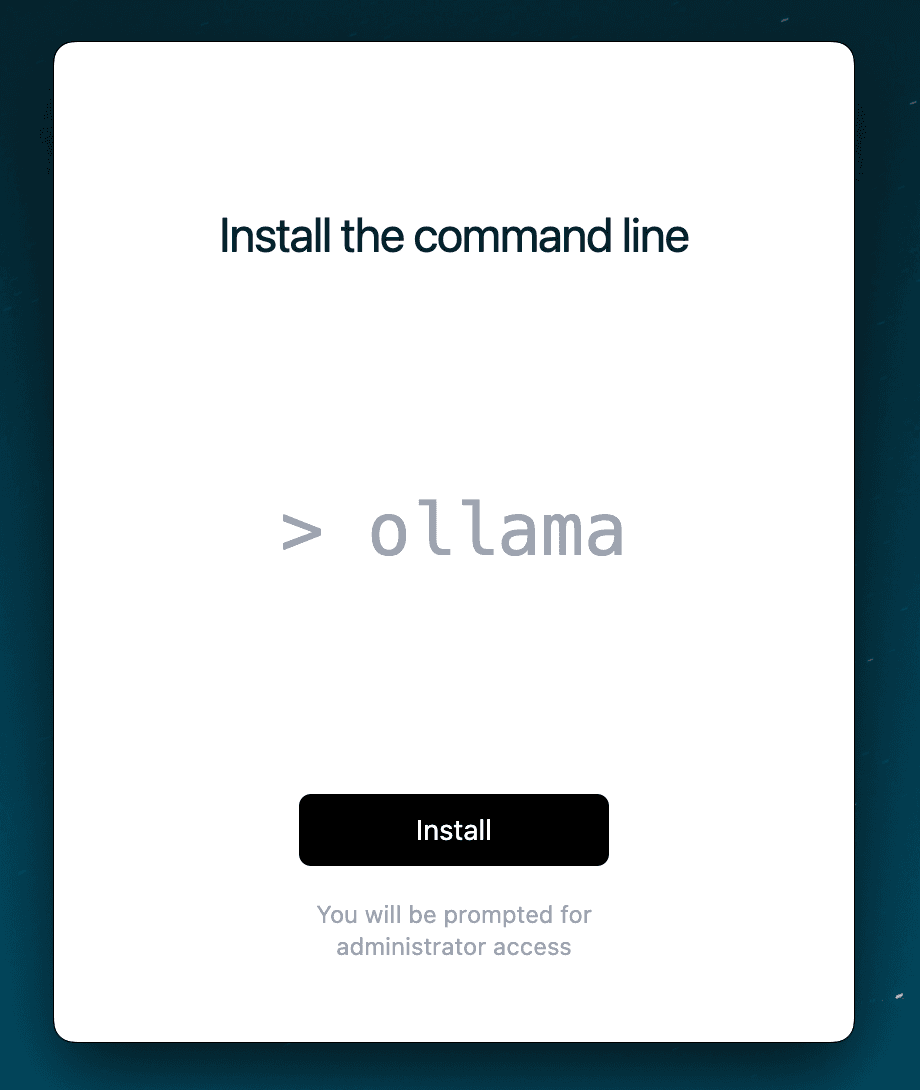

Nextをクリックすると、以下のようにInstall the command lineと表示されます。ここでInstallボタンをクリックします。

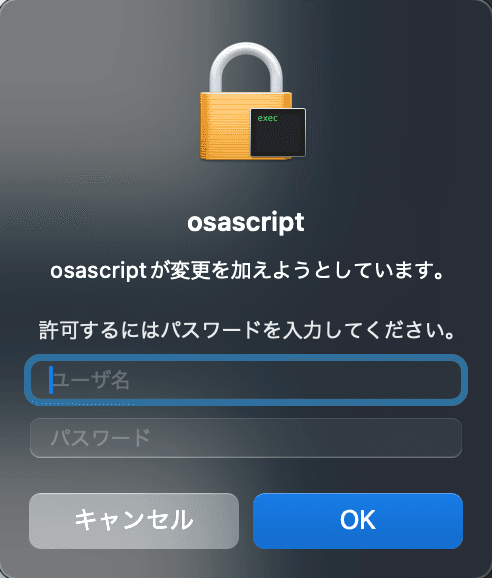

以下のように確認されます。macOS のユーザー名とパスワードを入力してOKをクリックします。

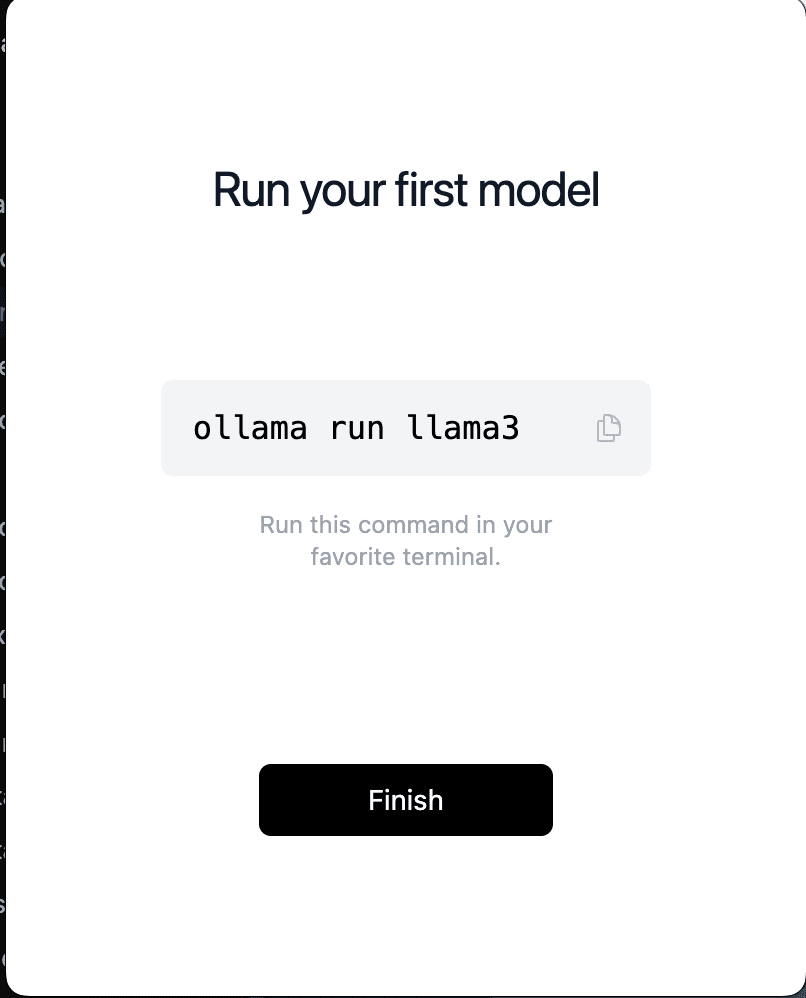

OKクリックすると以下のように表示されインストールが完了です。

Finishをクリックして閉じます。Finishをクリックしても何も表示されませんが、Ollama が動いている状態です。試しにターミナルを開いて以下を実行しバージョンを確認します。

$ ollama -v

ollama version is 0.1.38バージョンが表示されインストールできていることを確認できます。続いて以下を実行してLlama3を起動します。

$ ollama run llama3すると以下のようにllama3モデルのダウンロードが開始されます。サイズが 4.7GB ほどあり、少し時間がかかりますので完了するまで待機します。

$ ollama run llama3

pulling manifest

pulling 6a0746a1ec1a... 3% ▕ ▏ 152 MB/4.7 GB 16 MB/s 4m31s完了すると以下のように表示され、Send a messageと表示されています。ここにメッセージを入力して Enter を押下すれば、ChatGPT のように回答を返してくれます。

$ ollama run llama3

pulling manifest

pulling 6a0746a1ec1a... 100% ▕█████████████████████████▏ 4.7 GB

pulling 4fa551d4f938... 100% ▕█████████████████████████▏ 12 KB

pulling 8ab4849b038c... 100% ▕█████████████████████████▏ 254 B

pulling 577073ffcc6c... 100% ▕█████████████████████████▏ 110 B

pulling 3f8eb4da87fa... 100% ▕█████████████████████████▏ 485 B

verifying sha256 digest

writing manifest

removing any unused layers

success

>>> Send a message (/? for help)試しに適当に質問してみます。

>>> how are you ?

I’m just an AI, so I don’t have emotions like humans do. However, I’m functioning

properly and ready to assist you with any questions or tasks you may have. How can

I help you today?ちなみに、日本語で質問すると以下のような回答が返ってきます。

>>> こんにちは

こんにちは!😊 How are you today一応日本語も部分的に回答してくれますが、以下のように基本的には英語での回答が返ってきました。

>>> 日本の首都はどこですか?

That’s an easy one! 🙏 The capital of Japan is Tokyo (, Tokyō).Ollama を停止して終了する

Ollama を停止するには、Ctrl + Dのショートカットキーを入力するか、もしくは以下のように/byeを入力して会話を終了します。

>>> /bye会話を終了しても Ollama は起動状態のため、Ollama 自体を終了するには以下のようにメニューバーに表示されている Ollama のアイコンを右クリックして表示されるQuit Ollamaをクリックします。

記事執筆時点ではollamaのコマンドからは Ollama を終了できないようなので、ターミナルで Ollama のプロセスを確認し、終了します。

$ pgrep ollama

83744上記のように Ollama のプロセス ID が表示されるので、以下で終了します。

$ kill 83744他に使用できる AI モデルについて

Ollama では Llama3 以外のモデルも使用でき、以下にデフォルトで使用できるモデルがリストされています。

例えば、Microsoft 社のPhi3 Miniを使用したい場合は以下のようにすることで動かすことができます。

$ ollama run phi3Ollama がサポートしていないモデルを動かしたい場合は、Modelfileという使用する AI モデルの指定や指示を指定するためのファイルを使います。Modefileを使って日本語モデルを動かしてみる記事については別途まとめます。

まとめ

macOS で Ollama を使って Llama3 を動かすまでの手順を解説しました。今回使った Macbookpro M1 Pro だと回答までにかかる時間も数秒と早かったです。また、Ollama を使うことで非常に簡単に Llama を試すことができました。 Ollama を使うと、独自の指示を事前に指定したり回答方法について指定したモデルを使っての回答もさせることができるため、ちょっとした業務用途などにもかなり使えそうな印象です。